Installa l'app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Nota: This feature may not be available in some browsers.

Discussione Scaricare un sito

- Autore discussione Libroe

- Data d'inizio

Stai usando un browser non aggiornato. Potresti non visualizzare correttamente questo o altri siti web.

Dovreste aggiornare o usare un browser alternativo.

Dovreste aggiornare o usare un browser alternativo.

Puoi usare un software come HTTrack per effettuare il download automatico delle pagine web in questione. Potresti anche valutare l'opzione di non scaricare il sito e di recarti sul portale "www.archive.org": si tratta di un progetto che raccoglie la copia di tutti i siti internet del passato. In questo modo puoi visualizzare com'era fatto il sito che attualmente è stato chiuso.Come faccio a scaricare un intero forum per poter leggere i post etc anche se chiude? È un forum su forumfree.

Non ci sono riuscito con httrack, sicuro funziona al 100%?Puoi usare un software come HTTrack per effettuare il download automatico delle pagine web in questione. Potresti anche valutare l'opzione di non scaricare il sito e di recarti sul portale "www.archive.org": si tratta di un progetto che raccoglie la copia di tutti i siti internet del passato. In questo modo puoi visualizzare com'era fatto il sito che attualmente è stato chiuso.

se il sito chiude, c'è poco da fare chiaramente...

comunque come già ti hanno riferito, HTTRACK penso sia la scelta migliore.

comunque come già ti hanno riferito, HTTRACK penso sia la scelta migliore.

Certo che funziona, bisogna accertarsi di utilizzarlo correttamente però: hai provato a cercare una guida in rete?Non ci sono riuscito con httrack, sicuro funziona al 100%?

Ultima modifica:

Ma se sono 2 pagine di un topic per esempio e clicco su pagina 2 ci va o non funziona?Attenzione httrack scarica le pagine html che semplicemente puoi vedere anche con il browser, ovviamente script PHP non vengono scaricati.

In parole brevi puoi scaricare il frontend ma non il backend.

Messaggio unito automaticamente:

Dopo provo a scaricarlo.

si dovrebbe funzionareMa se sono 2 pagine di un topic per esempio e clicco su pagina 2 ci va o non funziona?

Messaggio unito automaticamente:

Dopo provo a scaricarlo.

Ultima modifica:

Ovvero? Scarica l'intero sito come httrack?ma wget da riga di comando vi fa schifo?

Messaggio unito automaticamente:

Non capisco come funziona httrack, faccio nuovo progetto, metto il nome e mi porta a questa schermata, qui metto l'url e faccio scarica sito, premo avanti ma non fa il download

Messaggio unito automaticamente:

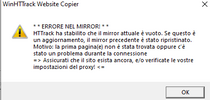

Mi da questo errore

Allegati

Ultima modifica:

Il sito è stato chiuso molto probabilmente. Non puoi scaricare un sito se non è più online, in rete. Prova ad utilizzare archive.org e vedi se riesci a scaricare qualche pagina da lì.Ovvero? Scarica l'intero sito come httrack?

Messaggio unito automaticamente:

Non capisco come funziona httrack, faccio nuovo progetto, metto il nome e mi porta a questa schermata, qui metto l'url e faccio scarica sito, premo avanti ma non fa il download

Messaggio unito automaticamente:

Mi da questo errore

Non è chiuso il sito. C'è un altro modo oltre httrack che non sia scaricare una pagina alla volta?Il sito è stato chiuso molto probabilmente. Non puoi scaricare un sito se non è più online, in rete. Prova ad utilizzare archive.org e vedi se riesci a scaricare qualche pagina da lì.

Ultima modifica:

wget https://nomesito.com , trovi il manuale lanciando man wget da terminale o cercando su google, se non c'è il tools lo installi con sudo apt install wget (vado a memoria) la base regà, la base.Probabile che alcune sezioni contengano materiale accessibile solo agli utenti registrati, in quel caso ti registri e usi le opzioni di autenticazione di wget.

Visualizza il file di log che ti compare e mostra l'errore. Molto probabilmente è come dice Psycho, ossia alcune sezioni del sito registrate nel server sono private e il server risponde con lo status 403: la scansione, quindi, viene interrotta.Non è chiuso il sito. C'è un altro modo oltre httrack che non sia scaricare una pagina alla volta?

Se non ricordo male con wget non la interrompe, solamente non ti scarica le pagine in cui non hai i permessi, al massimo dovrebbe esserci un opzione per il force.Visualizza il file di log che ti compare e mostra l'errore. Molto probabilmente è come dice Psycho, ossia alcune sezioni del sito registrate nel server sono private e il server risponde con lo status 403: la scansione, quindi, viene interrotta.

Sono sicuro al 99% che l'utente non sta utilizzando Linux ahaha. In ogni caso, wget è già preinstallato sui SO Linux, non c'è bisogno di installare niente...anche se ho visto che c'è una versione di wget anche per Windowswget https://nomesito.com, trovi il manuale lanciandoman wgetda terminale o cercando su google, se non c'è il tools lo installi consudo apt install wget(vado a memoria) la base regà, la base.

Probabile che alcune sezioni contengano materiale accessibile solo agli utenti registrati, in quel caso ti registri e usi le opzioni di autenticazione di wget.

Ecco qui una guida

Messaggio unito automaticamente:

Ah ok, pensavo usasse Linux come SO, comunque anche su powershell gira wget, è un alias del comandoSono sicuro al 99% che l'utente non sta utilizzando Linux ahaha. In ogni caso, wget è già preinstallato sui SO Linux, non c'è bisogno di installare niente...anche se ho visto che c'è una versione di wget anche per Windows

Invoke-webrequest qui una guida per WinzozLo sai che non ho mai provato? Non ho mai scaricato più di una risorsa con wgetSe non ricordo male con wget non la interrompe, solamente non ti scarica le pagine in cui non hai i permessi, al massimo dovrebbe esserci un opzione per il force.

, quindi non so come si comporta con più pagine, ma posso sempre provare. Poi ci stanno le varie flag, come dici tu, quindi basta sperimentare un po'.

, quindi non so come si comporta con più pagine, ma posso sempre provare. Poi ci stanno le varie flag, come dici tu, quindi basta sperimentare un po'.A lavoro c'ho fatto un pò di script per scaricare manuali xD o per controllare la risposta dei siti, si può usare anche curlLo sai che non ho mai provato? Non ho mai scaricato più di una risorsa con wget, quindi non so come si comporta con più pagine, ma posso sempre provare. Poi ci stanno le varie flag, come dici tu, quindi basta sperimentare un po'.

curl è molto comodo perché ti permette di cambiare anche gli headers delle richieste http per modificare i cookies, ad esempio.A lavoro c'ho fatto un pò di script per scaricare manuali xD o per controllare la risposta dei siti, si può usare anche curl

Un'altra alternativa sarebbe quella di usare un tool come dirb, gobuster, fuff per enumerare tutte le sottocartelle del dominio radice e inserirle in una lista. Fatto questo si può usare un for per scandire la lista e lanciare curl/wget per ogni elemento.

Un tempo usavo un programma che consentiva di scaricare tutto il sito con cartelle, file script usati, css ecc...

Non ricordo il nome ma non era difficile da usare.

Ovviamente non potevi scaricare articoli ecc ti scaricava solo la struttura in generale.

Non ricordo il nome ma non era difficile da usare.

Ovviamente non potevi scaricare articoli ecc ti scaricava solo la struttura in generale.

Forse httrack?Un tempo usavo un programma che consentiva di scaricare tutto il sito con cartelle, file script usati, css ecc...

Non ricordo il nome ma non era difficile da usare.

Ovviamente non potevi scaricare articoli ecc ti scaricava solo la struttura in generale.

DISCUSSIONI SIMILI

- 0

- 709

- 0

- 47

- 1

- 334

- 7

- 817